图片来源:N. Hanacek/NIST

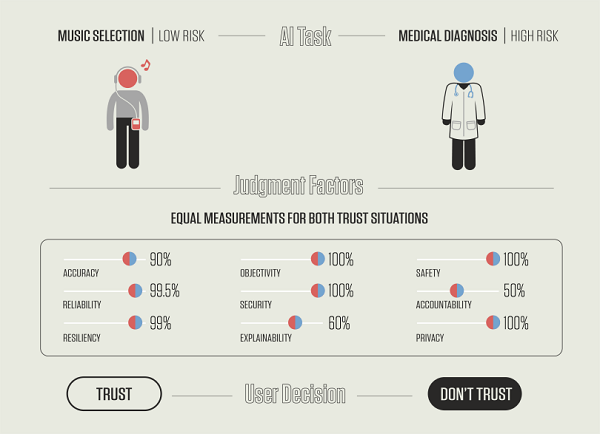

NIST在最新发布的报告中列出一份清单,清单包含9种指标,用于评估用户对AI系统的潜在信任度。用户根据任务本身和信任AI决策所涉及的风险对这9种指标进行权衡,例如,两不同的 AI 程序——音乐推荐算法和癌症辅助诊断AI系统。即使它们在9种指标上得分相同,用户可能会倾向于信任音乐推荐算法,而不是风险更大的癌症辅助诊断AI系统。

每次和智能手机上的虚拟助手交谈时,你都是在同AI进行对话——例如,AI可以学习你的音乐偏好,并根据你的互动选择推荐歌曲。同时,针对具有高风险的事件,AI也可以帮助做出决策,例如帮助医生诊断癌症。这是两种截然不同的场景,但同样的问题贯穿于两者:我们如何决定是否信任机器的建议?

Stanton是一位心理学家,他与NIST的计算机科学家Ted Jensen共同撰写了这份报告。他们在很大程度上基于过去对信任的研究,从信任在人类历史中的整体作用以及它如何塑造人类的认知过程开始,逐渐转向与AI相关的独特信任挑战,而AI正迅速发展,承担超出人类能力范围的任务。

Stanton 说:“AI系统可以被训练去‘发现’大量数据中人类大脑难以理解的模式。例如,系统可能会连续监控大量视频信号,在其中一个视频信号中发现一个孩子掉进港口。我们不是要求自动化设备去做我们能做的工作,而是要求它去做人类无法独自完成的工作。”

NIST的报告列出了具有9个指标的清单,这些指标有助于评估人们对AI系统的潜在信任度,这些指标与AI 开发人员和从业者建立的可信赖 AI 的技术要求不同。报告展示了一个人如何根据任务本身和信任AI决策所涉及的风险来权衡不同的指标。

例如,其中一个指标是准确度。如果是音乐推荐算法,那么不需要太准确,尤其是当一个人很好奇,想要摆脱自己的惯性去体验新鲜感的时候——无论如何,跳到下一首歌是很容易的。这与去信任一个在癌症诊断中准确率只有90%的AI系统完全不同,因为后者风险非常大。 Stanton强调:报告将基于背景研究得出结论,该结论始终受益于公众的监督。我们提出一个AI用户信任度模型,这都基于他人的研究和认知基本原理。因此,我们希望获得科学界的相关反馈,以便对这些想法进行实验验证。

这是美国国家标准与技术研究院(NIST)最新发布的一份报告中提出的问题,目的是激发人们对AI系统信任程度的讨论。这份名为《Artificial Intelligence and User Trust (NISTIR 8332)》的文件,将在2021年7月30日前公开征求公众意见。

该报告有助于进一步拓宽NIST的研究,推进可信赖AI系统的研发。报告重点了解人类在使用AI系统或受到AI系统影响时如何决定是否信任。Brian Stanton是该报告作者之一,也是NIST员工,他指出:关键问题在于人类对AI系统的信任是否是可测量的,如果是,应如何对其进行准确的测量。许多因素会被纳入我们关于信任的决定中,这是用户对系统的想法和感受,以及对使用系统所涉及的风险的感知。